¿Cómo se capacita a quienes califican los portafolios de las y los operadores del Sistema de Justicia Penal?

Erika Canché Góngora

Investigadora en el CEEAD

La evaluación de habilidades que sustenta la Certificación para la Justicia en México (CEJUME) se basa en la valoración del desempeño profesional de operadoras y operadores del Sistema de Justicia Penal Acusatorio (SJPA). Para ello, es necesario desarrollar instrumentos válidos que nos permitan saber con la mayor precisión con qué calidad se ejecutan las prácticas a evaluar, evitando hacer interpretaciones erróneas o descontextualizadas. Por ello, en el CEEAD optamos por una evaluación de portafolios basada en casos.

Una parte importante de la evaluación es identificar cómo se obtiene la información que va a sustentar un juicio de valor. El portafolios se integra a partir de tareas evaluativas, las cuales recogen evidencia de la capacidad de argumentación jurídica, toma de decisiones, comunicación de pretensiones e incluso de resolución de problemas de las y los profesionales que operan el SJPA y del personal capacitador de estos operarios. En la evaluación de portafolios importa lo que la persona sabe y también cómo utiliza el conocimiento para enfrentarse a determinada situación en determinado momento.

El otro elemento fundamental en el diseño del portafolios de evaluación es la construcción de rúbricas a partir de las cuales se valorará el desempeño observado. Las rúbricas de calificación son herramientas de estandarización que proporcionan una medida válida, confiable y basada en artefactos -evidencias de la práctica- (Borko, et. al. 2005) de las personas que sustentan la evaluación y que cumplen con una función formativa. Las rúbricas consisten en matrices, en donde se cruzan criterios de evaluación con niveles de desempeño y en las intersecciones se elaboran descriptores que caracterizan los distintos niveles de desempeño de manera cualitativa.

Para cada tarea evaluativa se construyen rúbricas con varios criterios o cualidades a observar en las respuestas a las tareas evaluativas. Su construcción y uso requieren de la mayor objetividad y fundamentación sobre lo observado, por ello, son desarrolladas por grupos colegiados de expertos con conocimiento y experiencia en el dominio a evaluar.

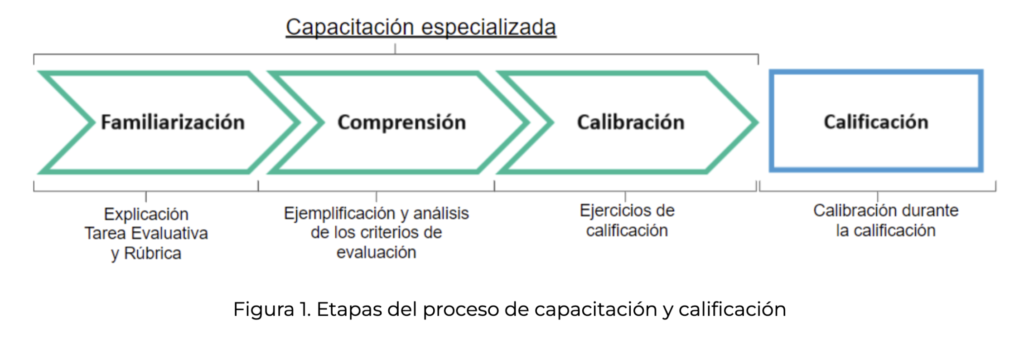

Evaluar mediante rúbricas representa uno de los mayores retos en evaluación del desempeño profesional, pues su potencial depende en gran medida, del personal calificador, principal usuario de la rúbrica que debe ser un par cuidadosamente seleccionado, capacitado, entrenado y supervisado durante todas las etapas del proceso de valoración (Fig. 1) y calificación de las respuestas, así como de las ejecuciones que observa, con el fin de evitar sesgos y obtener puntuaciones precisas de manera consistente.

Figura 1. Etapas del proceso de capacitación y calificación

Capacitación especializada

Quienes califican las respuestas o ejecuciones producto de las tareas evaluativas requieren de una trayectoria profesional sólida en la función a evaluar la cual, además de permitirles comprender los distintos matices del ejercicio profesional, también les permita aprovechar de su experiencia para dotar de validez este proceso. La capacitación de las personas que van a calificar representa una de las etapas más desafiantes del proceso evaluativo, debido a que para la mayoría de las y los participantes es el primer acercamiento a una rúbrica de calificación, al análisis de prácticas específicas en las cuales ellos son expertos y a la discusión de ejemplos paradigmáticos que han sido seleccionados previamente para provocar discusiones con la finalidad de favorecer la comprensión de lo que se evalúa.

La intención de realizar una capacitación que incorpora ejercicios de calificación de respuestas reales mediante las rúbricas a través de dinámicas de discusión, representa una metodología de trabajo que también tiene la intención de construir colectivamente acuerdos sobre la interpretación y uso de la rúbrica. Dichos acuerdos tendrán un impacto en la estandarización de los juicios de las personas que califican, con ello, en la validez y confiabilidad de la evaluación (Bejar, 2012).

Durante los ejercicios de discusión, el personal calificador tiene la oportunidad de reflexionar sobre sus propios juicios y sobre el de los demás. También, tiene que compartir su interpretación sobre el nivel de desempeño observado y el nivel esperado en cada criterio de la rúbrica. Estos ejercicios colectivos entre calificadores han demostrado ser útiles para reducir discrepancias y sesgos, así lograr un modelo común de juicios alrededor de un mismo criterio y finalmente reflejar ese juicio en un nivel de desempeño. Este intercambio de justificaciones generado durante cada una de las oportunidades de calificar usando la rúbrica ha resultado ser de vital importancia para controlar todos los supuestos, creencias o información alterna a lo que se pretende evaluar.

Durante el seguimiento de este tipo de capacitaciones, quienes han coordinado las distintas sesiones han tenido la oportunidad de notar y atender problemáticas del personal calificador en cuanto a:

- La forma en la cual procesan tanto la información de la rúbrica como la que nos brindan quienes sustentan la evaluación

- Las creencias preexistentes sobre cómo debe ser la práctica que califican

- La forma en la cual valoran determinada información por encima de otra

Tener conocimiento de este tipo de obstáculos nos ha permitido vigilar que las siguientes etapas de monitoreo y calificación sean más pertinentes y precisas.

Calibración durante la capacitación

Cada una de las personas calificadoras tiene experiencias propias, creencias e ideas sobre la práctica a evaluar y ello representa información importante que probablemente tienden a colocar en los juicios de valor que estén asignando. Esta problemática no es simple y pretender eliminar todo tipo de conocimiento previo es prácticamente imposible, por ello esta estrategia de capacitación asume la preexistencia de estos criterios “alternos” a la rúbrica y parte de la consideración de que la mejor forma de apropiarnos de un conocimiento es mediante un uso o aplicación reiterada.

Por ello, se han diseñado actividades de calibración durante la capacitación y durante todo el proceso de calificación. Durante la etapa de capacitación, la calibración consta de ejercicios guiados de uso de la rúbrica diseñados para generar discusiones críticas con la intención de dar oportunidades de familiarización con lo cual mide cada criterio de evaluación, comunicar dónde cada participante ubica el desempeño y cómo lo traduce en un nivel de logro de dicho desempeño.

El objetivo de esta calibración es detectar el grado de apego de quienes califican a los criterios de evaluación de la rúbrica y notar de manera oportuna juicios característicos de un calificador o calificadora muy exigente o muy condescendiente (Gitomer, et al. 2014). Asegurar que la rúbrica es el marco de referencia que norma cada una de las puntuaciones asignadas, es el reto a comunicar. Lograr que las personas calificadoras recurran a la autodetección de sus sesgos durante todo el proceso, es la meta por cumplir.

Hemos aprendido que cuando los períodos de calificación son extensos es muy probable que estos criterios externos a la rúbrica vuelvan a surgir, e incluso, se vayan acumulando debido a la exposición de distintas respuestas observadas en una variedad de contextos. Por ello, durante el proceso de calificación quienes participan realizan frecuentemente la calificación de la misma producción y reciben retroalimentación específica al respecto.

Otras estrategias

Otras estrategias implementadas en el CEEAD, ante el incremento del número de portafolios a calificar y para asegurar el apego a las rúbricas, fue la de crear una figura con la función de coordinar los procesos de calificación. Esta persona también es un par y monitorea todo el proceso desde la capacitación hasta la finalización del proceso de calificación de un grupo determinado de calificadoras y calificadores.

Los aspectos a evaluar en cada una de las rúbricas y el conocimiento de todos los factores que pueden influir en la calificación, son fundamentales para un buen desempeño del personal coordinador. El monitoreo constante de la asignación de niveles de desempeño, así como el análisis de justificaciones brindada por cada persona calificadora, ayuda a detectar sesgos y promover que se asignen niveles de forma precisa y consistente.

Finalmente es importante destacar la importancia de elaborar materiales y herramientas de apoyo tanto en la capacitación como en la calificación. Por ello diseñamos un repositorio en el que tanto personal coordinador como calificador tiene acceso al manual, el cual contiene explicaciones extensas de términos importantes de cada rúbrica, ejemplos paradigmáticos como guía durante las discusiones de capacitación que funcionan como código maestro (master code), pues contiene no solo acuerdos generados en capacitación sino una variedad de ejemplos y justificaciones que ejemplifican los principales atributos involucrados en las rúbricas de calificación.

Bibliografía

- Bejar, I. (2012). Rater cognition: Implications for validity. Educational Assessment, 31(3), 2-9. 10.1111/j.1745-3992.2012.00238.x

- Borko, H., Stecher, B. M., Alonzo, A. C., Moncure, S., & McClam, S. (2005). Artifact packages for characterizing classroom practice: A pilot study. Educational Assessment, 10(2), 73- 104. 10.1207/s15326977ea1002_1

- Engelhard, G. (2002). Monitoring raters in performance assessments. In G. Tindal & T. Haladyna (Eds.), Large-scale assessment programs for all students: Validity, technical accuracy, and implementation (págs. 261-287). Mahwah, NJ: Lawrence Erlbaum.

- Gitomer, D., Bell, C., Qi, Y., Croft, A. Leusner, D., Mccaffrey, D. & Pianta, R. (2014). Improving observational score quality: Challenges in observer thinking.